GenAI, raddoppiate le violazioni delle policy sui dati nel 2025

Nel 2025 l’uso dell’intelligenza artificiale generativa nelle aziende è cresciuta a ritmi vertiginosi, ma la sicurezza non ha tenuto il passo. Secondo il sesto report annuale di Netskope Threat Labs, le violazioni delle policy sui dati legate alla GenAI sono più che raddoppiate rispetto al 2024, evidenziando un divario sempre più ampio tra adozione tecnologica e capacità di controllo da parte delle organizzazioni.

I numeri sono indicativi: in media, le aziende registrano 223 tentativi al mese da parte dei dipendenti di inserire dati sensibili (come proprietà intellettuale, codice sorgente e credenziali) all’interno di prompt o caricamenti verso strumenti di GenAI. Parallelamente, la percentuale di lavoratori che utilizza questi strumenti su base mensile è triplicata, arrivando al 15%. Ancora più marcata la crescita dei volumi: i prompt inviati sono passati da una media di 3.000 a 18.000 al mese, con il 25% delle organizzazioni più attive che supera quota 70.000 prompt mensili. Anche l’ecosistema di applicazioni si è ampliato rapidamente: gli strumenti di GenAI monitorati da Netskope hanno superato i 1.600, cinque volte in più rispetto all’anno precedente.

A complicare ulteriormente il quadro c’è il fenomeno della “shadow AI”. Quasi la metà degli utenti AI (47%) continua a utilizzare account personali di strumenti di GenAI sul lavoro, al di fuori del controllo dei team di sicurezza, anche se il dato è in calo rispetto al 78% dell’anno scorso. Una tendenza simile riguarda le applicazioni cloud personali: il 31% dei dipendenti carica dati ogni mese e il 60% degli incidenti di minaccia interna è legato proprio a questo tipo di utilizzo.

Nonostante la crescente esposizione al rischio, le contromisure restano insufficienti. Solo il 50% delle organizzazioni ha implementato soluzioni di Data Loss Prevention per impedire la divulgazione di dati sensibili tramite applicazioni di genAI. In pratica, una azienda su due non dispone di controlli in tempo reale in grado di consentire l’uso dell’AI prevenendo al contempo la fuga di informazioni. Ancora più critica la situazione sul fronte cloud personale: il 23% delle organizzazioni non ha alcun controllo in tempo reale per rilevare o bloccare la perdita di dati.

“L’adozione del cloud e dell’AI sta trasformando rapidamente sistemi e comportamenti, introducendo rischi che hanno colto molti team di sicurezza di sorpresa -, spiega Ray Canzanese, Director di Netskope Threat Labs -. È urgente aggiornare policy e misure di protezione, estendendo strumenti come il DLP, per trovare un equilibrio tra innovazione e sicurezza”.

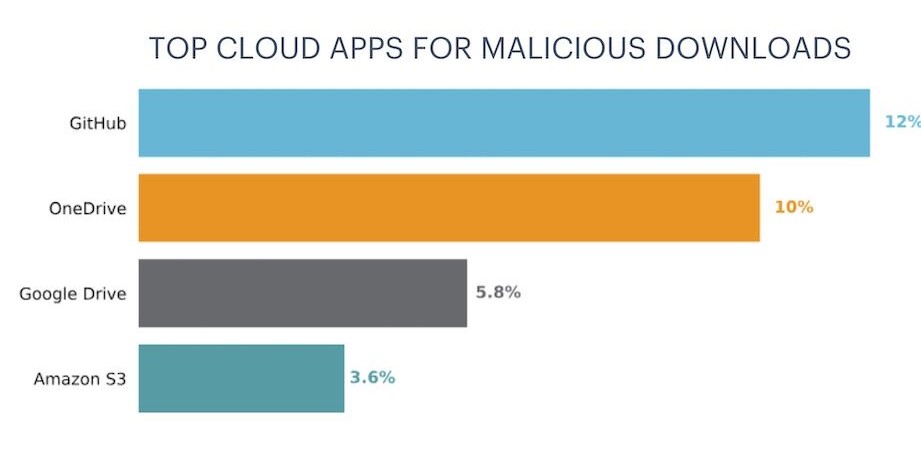

Sul fronte delle minacce esterne, phishing e malware restano problemi persistenti. Anche se la suscettibilità al phishing è diminuita del 27% su base annua, nel 2025 ben 87 dipendenti ogni 10.000 cliccano ancora ogni mese su link malevoli. Gli attaccanti puntano sempre più al furto di credenziali cloud, sfruttando pagine di login contraffatte, applicazioni OAuth malevole e l’impersonificazione di brand noti. Microsoft è oggi il marchio più falsificato, seguito da Hotmail e DocuSign. Per il malware, i servizi cloud restano il canale preferito: GitHub, OneDrive e Google Drive sono tra le piattaforme più abusate, sfruttate per diffondere file infetti in contesti percepiti come affidabili dagli utenti.

data security, DLP, GenAI, policy, shadow AI